개발분야에서 claude가 인기 있다 보니 문서들이 claude 기반의 자료가 많다.

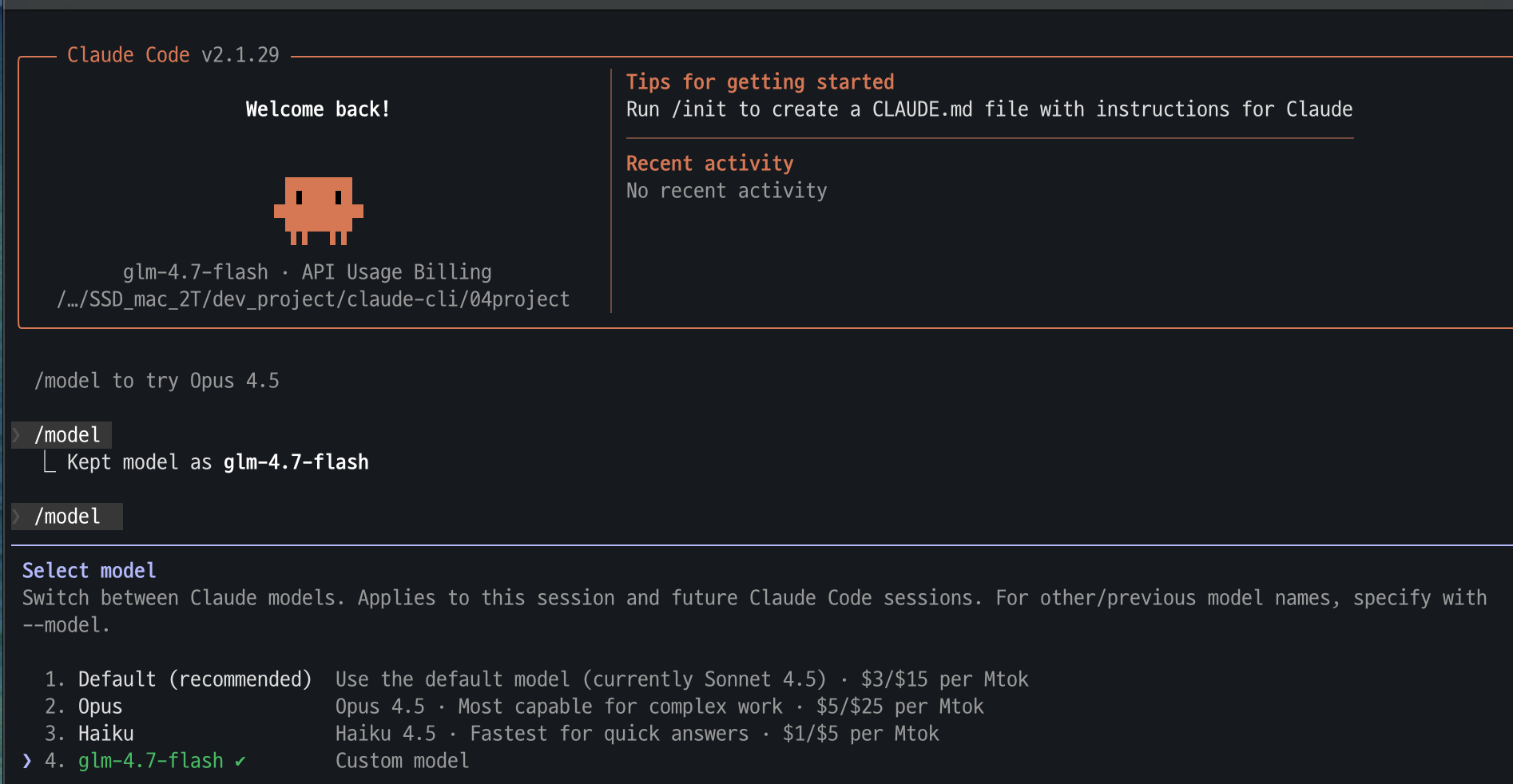

그래서 한번 calude-cli가 local LLM을 사용하여 claude의 I/F를 사용해 보고자 한번 설정을 해봤다.

결론은 돈 주고 상용 서비스를 이용하자!!!!

1. 소요 시간

코드 생성은 5단계로 구분하여 단계별 개발 프롬프트는 동일한 것을 사용하였다. 개발 프롬프트는 혼공바이브코딩 도서에서 제공된 PRD를 사용하였다.

| 소요 시간 : claude + local LLM : 2시간이 넘는것 같죠 | 소요 시간 : gemini-cli1분이내 |

|

|

2. 생성물

둘다 비슷하게 잘 만들었다.

| Claude + Local LLM | gemini-cli |

|

|

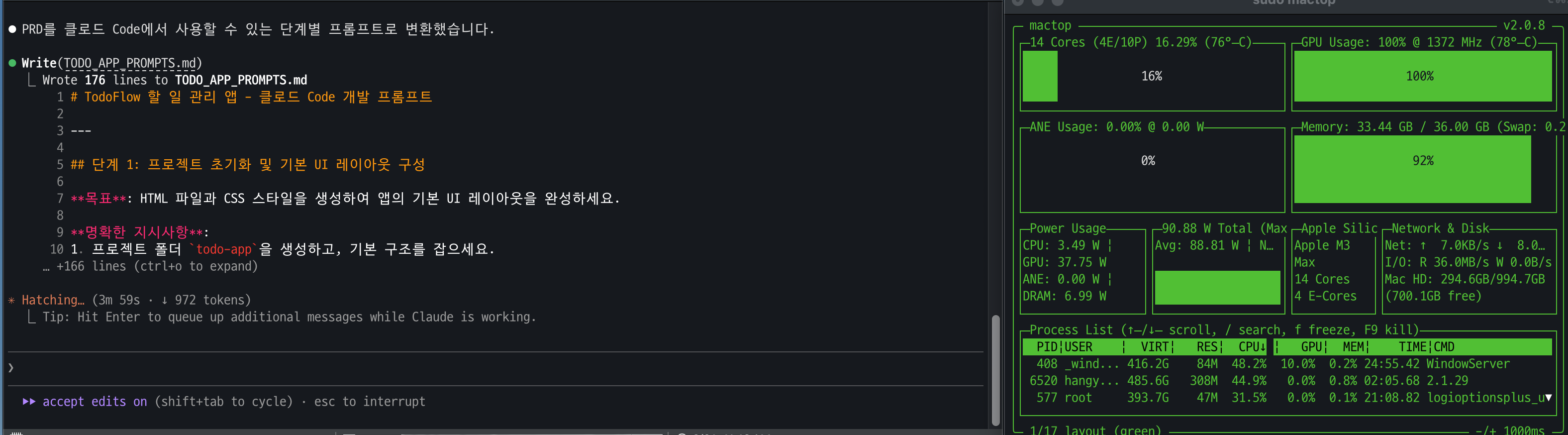

3. 리소스 사용

claude + local LLM으로 코딩을 하니.. gpu 다잡아 먹고, 전원 만땅으로 쓰고, 팬 만땅으로 돌아가니 팬소리 시끄럽니다.

CPU, MEM, HDD등의 리소스 사용율이 70% 이상 못하게 하는 것이 지금까지의 철칙인데... 그 철칙이 깨졌다..

4. Claude + Local LLM 환경을 구축하고 싶다면..

아래 2개의 자료를 참고 했다.

https://www.youtube.com/watch?v=aV3jbFdYfLs

간단 요약

- claude 설치 curl -fsSL https://claude.ai/install.sh | bash

- ollama 환경설치

- LLM model download (glm-4.7-flash 또는 qwen-code)

- claude가 ollama 사용하도록 환경 변수 설정

- export ANTHROPIC_AUTH_TOKEN=ollama

- export ANTHROPIC_BASE_URL=http://localhost:11434

- Ollama context length 4k —> 64K 변경

- claude 실행 (나는 1번으로 실행)

- $ claude --model glm-4.7-flash

- $ claude --model glm-4.7-flash

- model이 ollama에서 설치한 LLM확인

'바이브 코딩 > 바이브 코딩 일반' 카테고리의 다른 글

| 바이브 코딩 개발론 (0) | 2026.02.14 |

|---|---|

| 바이브 코딩 자료들 (0) | 2026.01.25 |

| Agent Skill (0) | 2026.01.23 |

| 구글 바이브코딩 툴 (0) | 2026.01.16 |

| 바이브 코딩 자료 (1) | 2026.01.15 |